KI-Agenten gelten als nächste Evolutionsstufe der Automatisierung. Sie recherchieren, entscheiden und handeln. Viele Unternehmen verfolgen dabei ein klar definiertes Ziel: möglichst viel Autonomie. Doch genau hier entsteht ein durchaus überraschender Effekt: Das KI-Agenten-Paradoxon.

KI-Agenten gelten als nächste Evolutionsstufe der Automatisierung. Sie recherchieren, planen, entscheiden und handeln eigenständig. In vielen Unternehmen dominiert dabei ein klares Leitbild. Möglichst viel Autonomie. Möglichst wenig menschliche Eingriffe.

Die dargestellten Zusammenhänge basieren dabei nicht auf einer einzelnen Studie, sondern auf der Synthese mehrerer Erkenntnisquellen. Dazu zählen praktische Erfahrungen aus unterschiedlichen Multi-Agent-Systemen wie AutoGPT, LangGraph oder CrewAI, ebenso wie Forschungsergebnisse zu Automation Bias und Over-Automation. Ergänzt wird dies durch etablierte Konzepte wie Human-in-the-Loop und Human-out-of-the-Loop sowie durch Parallelen zu bekannten systemtheoretischen Effekten, etwa den Ironies of Automation nach Bainbridge und Prinzipien der Control Theory.

Wenn Autonomie schneller wächst als Kontrolle

Autonome KI-Agenten treffen Entscheidungen auf Basis ihres lokalen Kontexts. Sie optimieren Schritt für Schritt. Was ihnen fehlt, ist ein übergeordnetes Verständnis für strategische Zielkonflikte, implizite Annahmen und langfristige Konsequenzen.

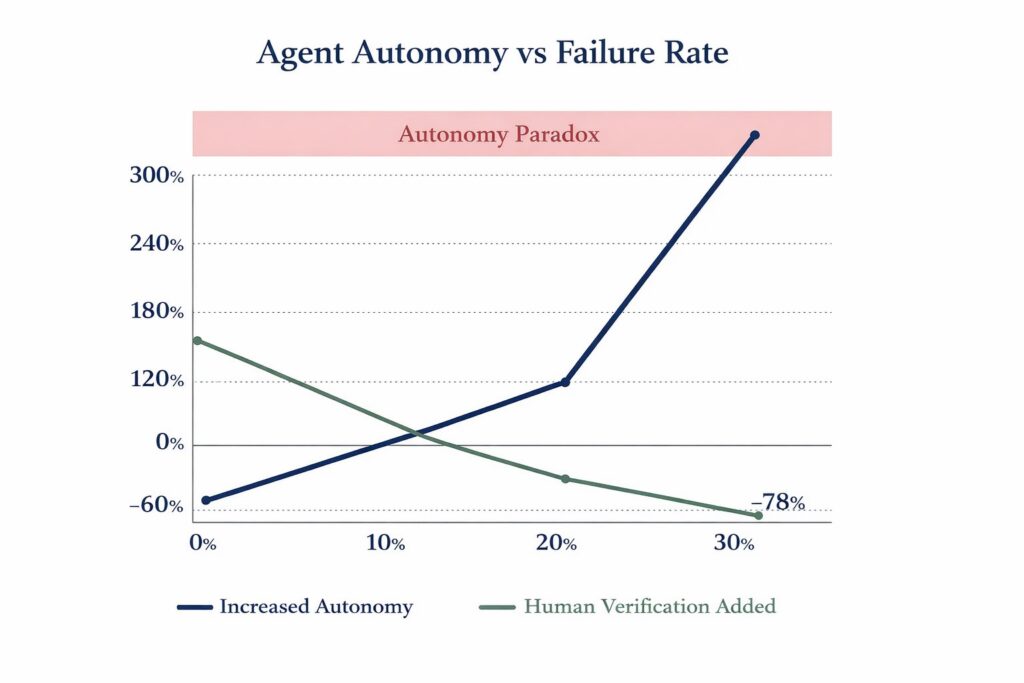

Je autonomer ein Agent agiert, desto mehr Entscheidungen trifft er ohne externe Rückkopplung. Kontrolle hingegen skaliert nicht automatisch mit. Menschen können komplexe Agentenketten mental nur begrenzt nachvollziehen. Das führt zu einem strukturellen Ungleichgewicht. Autonomie wächst exponentiell, Kontrolle nur linear.

Die Folge sind schleichende Fehler. Kleine Fehlannahmen wirken zunächst harmlos. Sie werden weiterverarbeitet, kombiniert und verstärkt. Jeder einzelne Schritt erscheint plausibel. Erst das Endergebnis ist offensichtlich falsch.

Warum lange autonome Laufzeiten riskant sind

Je länger ein KI-Agent ohne menschliche Eingriffe operiert, desto höher wird das Risiko systemischer Fehler. Nicht, weil das Modell schlecht wäre. Sondern weil sein Bewertungsrahmen begrenzt ist.

KI ist schnell, aber nicht reflektiv. Sie weiß nicht, wann sie innehalten sollte. Sie erkennt keine impliziten Zielverschiebungen. In offenen, mehrdeutigen Umgebungen wird genau das zum Problem. Geschwindigkeit ersetzt kein Urteilsvermögen.

Das Google Four Layer Model als Gegenentwurf

Ein besonders hilfreiches Denkmodell zur Einordnung liefert das Four Layer Model von Google. Es beschreibt, wie leistungsfähige KI-Systeme sinnvoll strukturiert werden sollten. Nicht als monolithische Autonomie, sondern als gestapeltes System mit klaren Rollen.

Layer 1. Modelle

Das Fundament bilden große Sprach- und Multimodalmodelle. Sie liefern Wahrscheinlichkeiten, Mustererkennung und generative Fähigkeiten. Sie treffen jedoch keine finalen Entscheidungen.

Layer 2. Orchestrierung und Agentenlogik

Hier agieren KI-Agenten. Sie zerlegen Aufgaben, planen Schritte, rufen Tools auf und koordinieren Prozesse. In diesem Layer entstehen Geschwindigkeit und Effizienz, aber auch das Risiko lokaler Optimierung.

Layer 3. Guardrails und Kontrolle

Dieser Layer ist entscheidend. Er definiert Regeln, Grenzen, Eskalationslogiken, Plausibilitätschecks und Freigabepunkte. Genau hier wird das KI-Agenten-Paradoxon entschärft. Nicht durch weniger KI, sondern durch bewusst gestaltete Eingriffe.

Layer 4. Menschliche Entscheidungsinstanz

Der Mensch sitzt nicht im operativen Kleinklein, sondern auf strategischer Ebene. Er überprüft Annahmen, priorisiert Ziele, bewertet Risiken und greift dort ein, wo Entscheidungen irreversible Folgen haben.

Das Modell macht klar. Autonomie ist kein Alles-oder-Nichts-Prinzip. Sie ist eine Designfrage.

Wenige Eingriffe, große Wirkung

Ein zentraler Effekt zeigt sich immer wieder. Schon wenige, gezielt platzierte menschliche Eingriffe reduzieren die Fehlerrate drastisch.

Freigabepunkte, Stichproben, Plausibilitätschecks oder Eskalationsregeln wirken wie Sicherheitsventile. Sie unterbrechen fehlerhafte Ketten, bevor sie teuer oder kritisch werden. Dabei geht es nicht um Mikromanagement. Es geht um strategische Interventionspunkte.

Kontrolle funktioniert dann, wenn sie nicht permanent ist, sondern relevant.

Intelligente Autonomie statt maximaler Autonomie

Erfolgreiche KI-Systeme setzen daher nicht auf maximale Autonomie, sondern auf intelligente Autonomie. Das bedeutet klare Entscheidungsgrenzen, definierte Risikoschwellen, transparente Zwischenergebnisse und eine bewusste Trennung zwischen Ausführung und Verantwortung.

Der Mensch ist dabei kein Störfaktor im System. Er ist der Stabilitätsanker.

Zusammenspiel von KI-Geschwindigkeit und menschlicher Entscheidungsintelligenz als wichtigster Hebel

Mehr Autonomie ist kein Selbstzweck. Der eigentliche Hebel liegt im Zusammenspiel von KI-Geschwindigkeit und menschlicher Entscheidungsintelligenz.

Wer das KI-Agenten-Paradoxon versteht, baut keine vollständig autonomen Systeme, sondern robuste Systeme. Systeme, die skalieren, ohne die Kontrolle zu verlieren. Systeme, die nicht nur schneller sind, sondern verlässlicher.

Die Zukunft gehört nicht der maximalen Autonomie. Sie gehört der klug gestalteten Zusammenarbeit zwischen Mensch und Maschine.